过去四十年,人与机器的交互方式在不断进化,几乎每十年就会有一次重大革新。来到人工智能时代,生活中越来越多的设备开始支持语音交互,语音交互逐渐成为人们传达意图和与设备交流的优先选择(Voice First)。与传统交互相比,语音交互解放了双手和双眼,人们可以低成本与设备互动;而且,语音是多维的,除了言语本身的信息,言语中还蕴含着丰富情感,允许人们与设备进行更充分的互动。

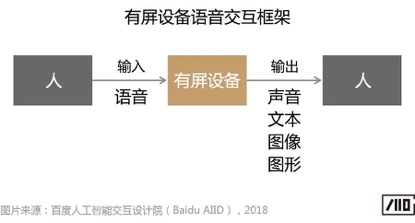

语音交互也有局限性。语音交互是非可视化的,容易增加人们的记忆负担,设想语音查询信息的场景,你可能需要集中精力听,如果不留神就容易错过一些内容。鉴于此,正如人工智能专家吴恩达提到的,人与机器交流最高效的方式是语言,而机器与人最高效的交流方式是语言加上视觉,即需要在听觉基础上融入视觉信息弥补语音交互的不足。从语音向视觉延伸,在语音交互中融入可视化信息,已经是业界探索下一代语音交互范式的重要趋势。以智能音箱为例,除了无屏音箱以外,市场上开始出现带屏幕的音箱。

百度人工智能交互设计院本期以有屏智能设备为研究对象,聚焦语音交互反馈和内容输出环节的体验。考虑到屏幕尺寸差异可能对反馈和内容输出体验的影响,研究选择了两种不同屏幕尺寸的设备,分别是智能音箱(7英寸)和智能电视(55英寸)。本期的主要研究问题包括:

1)有屏设备的指令上屏反馈体验,主要指用户输入语音指令后,文本指令上屏的延迟时间以及文本指令在屏幕上呈现的合理时间;

2)有屏设备内容输出的音量干扰体验,主要指用户在特定场景下(如听音乐/看视频),插入其它任务后(如查询百科),不同内容输出时的音量合理设置。

一、有屏设备的指令上屏体验研究

与无屏设备相比,显示屏的融入使语音交互过程有更丰富的反馈形式。以语音识别阶段为例,在无屏设备上,用户通常无法直接知道输入指令的识别结果。而有屏设备直接在屏幕上显示指令的识别结果,用户可以方便的查看识别结果的正确或错误情况,例如上屏后的指令"我要听周杰伦的青花瓷"。然而,目前很多设备在指令上屏时存在一定程度的延迟现象,本实验对指令上屏合理的延迟时间和呈现时间进行研究。

1、指令上屏延迟时间实验

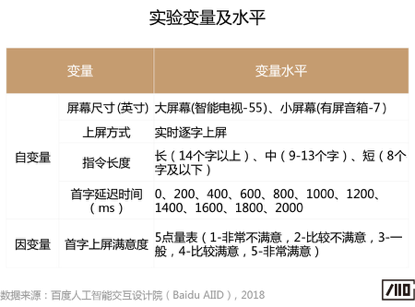

由于市场上的有屏设备多数采用实时上屏方式,即用户输入语音指令的同时就开始在屏幕上呈现识别结果,因此,本实验只研究实时上屏。在实验中我们使用实时逐字上屏的方式,并以控制首字上屏延迟时间为主要变量(注:首字上屏延迟时间指从用户开始说到第一个字上屏的时间间隔),我们设置了不同的首字延迟时间,以此获取用户对指令上屏速度的满意度评价(5点量表:1-非常不满意,2-比较不满意,3-一般,4-比较满意,5-非常满意)。在实验中,我们分别提供了3种不同长度的指令。

实验结果表明,首字延迟时间越短,用户的满意度越高,不同屏幕尺寸设备的首字延迟时间满意度略有差异,我们将"4-比较满意"看做用户满意的得分下限,将"3-一般"看做用户可接受的得分下限,不同设备间用户满意和可接受的上屏时间如下:

1)对于有屏音箱,用户满意的首字延迟时间下限在500ms左右,可接受的首字延迟时间下限在1500-1600ms左右;

2)对于智能电视,用户满意的首字延迟时间下限在600-700ms左右,可接受的首字延迟时间下限在1100-1200ms左右;

结合对市场上其它设备的研究发现,部分设备的首字上屏时间明显比用户满意的时间下限长,少数甚至比可接受的下限还要长。关于指令上屏速度,产品仍有改善和优化的空间,即语音识别ASR(Automatic Speech Recognition)技术除了在不断提升识别准确率以外,同时也需要关注识别速度指标的提升。

2、指令上屏呈现时间实验

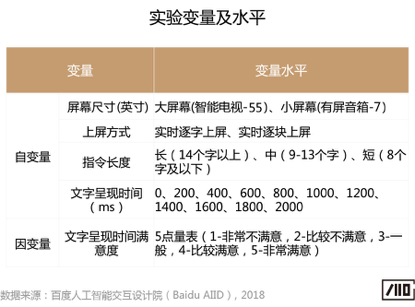

除了指令上屏时间,我们进一步对指令上屏后合理的呈现时间进行研究,以避免指令呈现时间太短导致用户无法看清,或者呈现时间太长导致整个交互过程拖沓冗余。在实验中,我们以文字呈现时间为主要变量(注:文字呈现时间指文本指令最后一个字上屏后到全部指令消失的时间间隔),获取用户对不同呈现时间的满意度评价。由于语音识别涉及语言模型技术,实际的指令上屏并不是逐字的方式,因此,本部分实验我们也模拟了逐块上屏的方式,以指令"我想看刘德华2010年以前主演的香港电影"为例,"刘德华"被整体识别后才上屏。在实验中,我们也分别提供了3种不同长度的指令。

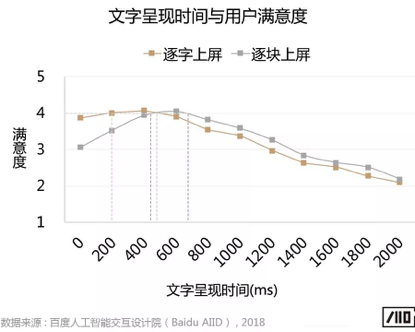

实验结果表明,存在最优的文字上屏呈现时间,不同屏幕尺寸设备之间,最优的文字上屏呈现时间无显著差异。不同上屏方式间存在差异,逐字上屏和逐块上屏的最优呈现时间分别如下:

1)逐字上屏方式下,最优的指令呈现时间为200-500ms的区间;

2)逐块上屏方式下,最优的指令呈现时间为400-700ms的区间。

由于逐块上屏方式更接近真实产品的上屏方式,因此建议主要参考400-700ms的呈现时间。需要说明的是,由于实时上屏的方式允许用户在输入语音指令过程中就可以查看已经上屏的文字,这与整体识别后上屏的方式明显不同,因此,如果产品采用的是整体识别后上屏的方式,不建议参考本部分实验的结论。

二、有屏设备的音量干扰体验研究

有屏设备除了使语音交互有更丰富的反馈以外,屏幕的引入也扩展了设备过去不具备的功能,例如视频内容消费和视频通讯能力等。同时设备的使用也在经历从过去单一任务到多个任务的变化,当看视频时,你可以随时插入任务查找信息,例如看电视剧《扶摇》时查询演员杨幂的信息。本部分实验主要研究用户插入任务后,前景内容和背景内容间的音量干扰体验,如当前景内容正在语音播报信息时,背景视频或音乐的合理音量范围,以避免过高的背景音对用户获取信息产生干扰。

1、音量干扰实验

在实验中,用户被要求分别在看视频和听音乐两种场景下进行信息查询。我们设置了两种初始音量(注:初始音量是用户看视频/听音乐的音量):60和65分贝,用户查询人物或百科信息后,通过设置不同的背景音量(注:此时前景内容为语音播报信息,背景内容为视频或音乐),获取用户对背景音量的满意度评价。同时结合实验后问卷了解用户对前景和背景信息展示的态度。由于不同设备间音量刻度范围存在差异,实验中对有屏音箱和智能电视的背景音量进行了分别设置。

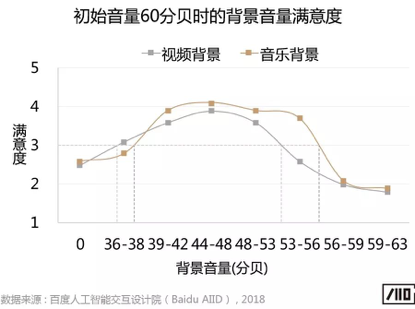

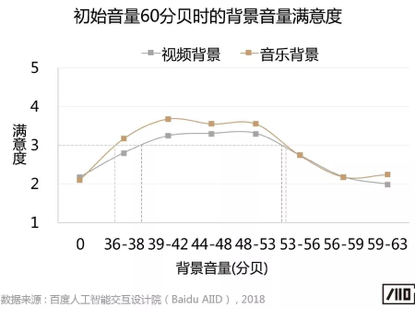

实验结果发现,无论背景是视频还是音乐,用户都不喜欢背景完全静音(注:下图中"0"代表背景完全静音)。针对有屏音箱和智能电视,当初始音量约为60分贝时,背景音量舒适范围略有差异,具体结果如下:

1)针对有屏音箱,背景视频音量下降至36-53分贝范围,背景音乐音量下降至39-56分贝范围时,用户主观感觉较舒适;

2)针对智能电视,背景视频音量下降至39-53分贝范围,背景音乐音量下降至36-53分贝范围时,用户主观感觉较舒适。

实验中我们同时研究了初始音量为65分贝时背景音量的舒适范围,因实验结果与上述趋势基本一致,篇幅所限,暂不一一展开。

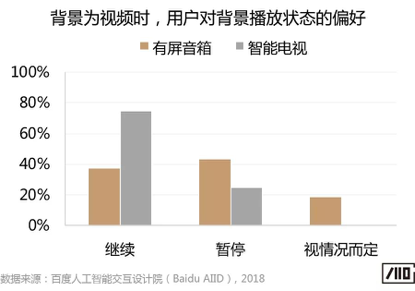

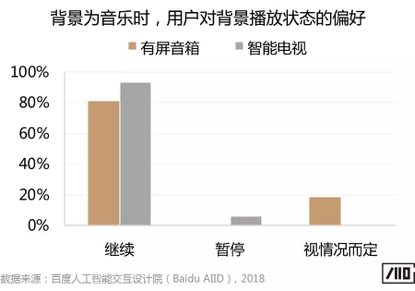

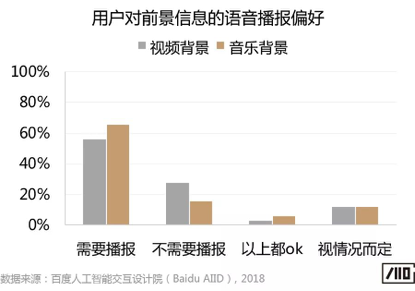

此外,结合实验后的问卷调研结果发现,关于背景的播放状态,背景为音乐时用户更倾向继续播放,而背景为视频时有屏音箱端倾向视频暂停的用户更多。主要是由于有屏音箱端背景视频被完全覆盖,因此,用户认为背景视频暂停较好,以避免错过感兴趣的视频内容。

关于前景内容的播放状态,无论屏幕尺寸差异和背景媒体类型,多数用户希望能够对前景信息进行语音播报,而不仅仅是在屏幕上以文字或图文的形式展示。

三、小结

本文针对有屏设备的语音交互体验进行研究,重点探索整合视觉系统后交互反馈和内容输出环节的体验问题。对指令上屏的延迟时间和指令呈现时间给出了我们的研究结果和设计建议,以及不同内容输出时前景和背景的合理音量设置等。

从语音向视觉的延伸,语音交互的边界和外延仍将不断变化。语音交互与传统的交互方式并不是互斥的、非此即彼的关系,未来的人机交互将融入听觉、视觉、触觉、味觉、嗅觉等多模态的交互方式。未来的交互范式必然不是这些交互方式的简单堆砌和罗列,而是在考虑特定场景、人的因素、环境条件等因素后有序的、合理的组合和设计。百度人工智能交互设计院也将会持续的关注多模态交互领域的研究和设计,并不断输出我们的研究成果和观点。

未来,语音交互,我们一起探索和进步。